Tecnologia da informação

A informática, a internet e a web

Entenda como a Informática, a Internet e a Web se desenvolveram e como elas se inseriam nas empresas e organizações.

Publicado em:

20 de ago. de 2019

Atualizado em:

24 de set. de 2022

Quando falamos em Tecnologia da Informação faltalmente direcionamos nossos estudo para algumas tecnologias específicas do nosso tempo: a informática, a Internet e a Web.

Ainda há muita confusão sobre o que é cada uma dessas tecnologias, principalmente no Brasil, onde confundimos internet com web.

Por isso o objetivo dessa aula é tratar sobre cada uma dessas tecnologias separadamente, situando seu surgimento na história e avaliando as consequências de cada uma sobre as empresas e organizações.

O Computador e a Informática

O computador é uma máquina de computar. Computar significa utilizar um determinado algoritmo, ou seja, uma lista de instruções preestabelecidas (programa), para se processar uma certa quantidade de dados, obtendo-se um resultado almejado.

Máquinas capazes de computar existem há vários séculos, porém suas capacidades eram limitadas e cada uma delas era capaz de realizar uma única função, como por exemplo realizar as opeações aritméticas básicas (adição, subtração, multiplicação e divisão).

Porém essas primeiras máquinas ainda não podem ser chamadas de Computadores pois tinham uma limitação: não eram programáveis, isto é, os usuários não podiam alterar suas funções. O surgimento dos computadores programáveis é, talvez, o marco mais importante na história da informática.

Uma etapa para esse importante avanço se deu com a adoção do sistema binário como base para todos os computadores e programas. Até o século XIX, os computadores erram essencialmente analógicos e eram construídos tendo como base a lógica decimal (com variáveis que vão de 0 a 9).

Isso começou a mudar em 1854 quando o matemático inglês George Boole publicou os princípios da lógica booleana, onde as variáveis assumem apenas valores 0 e 1 (verdadeiro e falso). A lógica booleana ou padrão binário passou a ser utilizada nos computadores a partir do início do século XX.

Os primeiros computadores programáveis baseados no sistema binário, precursores daqueles que utilizamos hoje, surgiram durante a Segunda Guerra Mundial, e foram criados pelas forças armadas dos Estados Unidos.

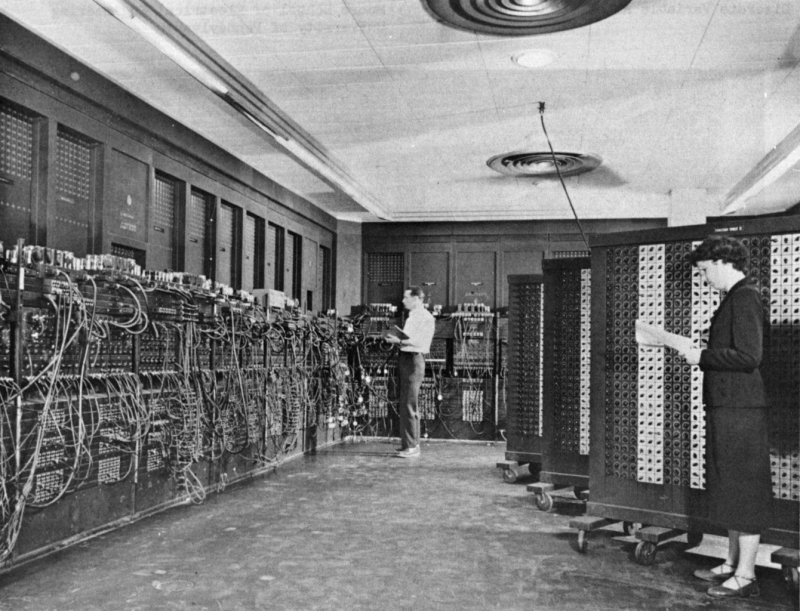

Na imagem você pode ver um deles, o Eletronic Numeric Integrator and Calculator ou ENIAC, que começou a ser desenvolvido em 1943. Esse computador era programável, pois seus operadores podiam alterar as conexões dos cabos e fiações dos painéis, alterando sua função para a realização de tarefas específicas. Depois de cada operação as conexões precisavam ser refeitas manualmente para a realização da próxima tarefa.

O ENIAC tinha como principal função a realização cálculos balísticos durante a Guerra. Possuía 17.468 válvulas termiônicas e sua capacidade de processamento era de 5.000 operações por segundo. Atualmente as válvulas foram substituídas pelos microchips e existem supercomputadores capazes de realizar um quintilhão de operações por segundo.

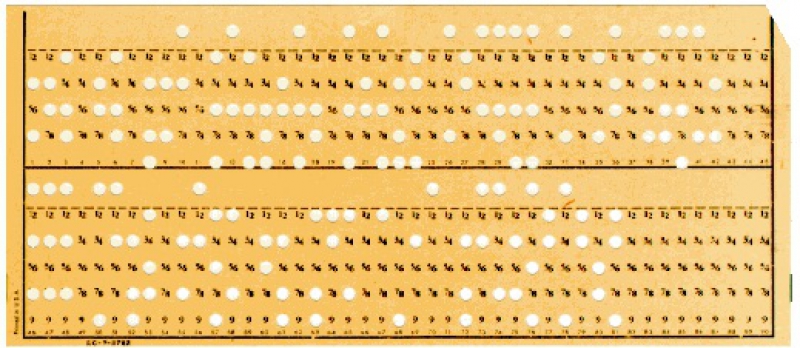

Outros computadores da mesma época, como o Z1 desenvolvido na Alemanha, recebiam as instruções de seus operadores por meio de cartões perfurados. Esses cartões eram lidos pelo computador e, caso não houvessem erros, suas instruções resultariam em um determinado resultado, na maioria das vezes muito simples.

Nessa época, o desafio dos cientistas da computação ainda era o de processar informações simples e as tecnologias que existiam não permitiam nem mesmo vislumbrar a possibilidade de se utilizar esse equipamento para representar ou produzir imagens. Perceba que o ENIAC nem possuía um monitor! Apenas no final da década de 1960 começaram a surgir protótipos de sistemas capazes de processar imagens, surgindo o que chamamos de computação gráfica.

DICA DE FILME:

O filme O Jogo da Imitação (2014) retrata a história real de Alan Turing, um cientista inglês que foi recrutado no final da II Guerra Mundial e particiou dos esforços para decifrar a criptografia utilizada pelos alemães. Ele cria um computador capaz de decifrar essa criptografia e interceptar as mensagens dos nazistas, ajudando os aliados a vencerem a guerra.

Computação Gráfica

O primeiro benefício que os usuários tiveram com a Computação Gráfica foi o surgimento das Interfaces Gráficas. Assim, ao invés de programar o computador por meio de cartões perfurados ou mudando a conexão de cabos, toda a operação da máquina passou a se dar a partir da interação com imagens exibidas na tela.

Mais tarde, o segundo benefício aos usuários trazido pela Computação Gráfica, foi a possibilidade de criação de Imagens Digitais. Os cientistas da computação criaram pelo menos dois métodos (Mapa de Bits e Vetores) para se armazenar e representar imagens com o código binário. Criaram-se então programas de computadores que os usuários pudessem utilizar esses métodos para produzir suas próprias imagens.

A Revolução do Computador Pessoal

Um marco importante na indústria da informática se deu com o surgimento do computador pessoal, ou personal computer (PC). Atá meados da década de 1970 as grandes empresas do setor tinham como paradigma o desenvolvimento dos chamados mainframes, ou computadores de grande porte, de modo que cada empresa ou universidade precisasse de apenas um ou poucos computadores para realizar todas as suas atividades informatizadas.

Nesse período alguns jovens universitários aficionados por tecnologia começaram uma verdadeira revolução. Nas garagens das casas de seus pais eles começaram a utilizar os recém criados microchips para produzirem computadores de pequeno porte, que ficariam conhecidos como computadores pessoais. A Apple e a Microsoft são empresas que surgiram nesse momento e conseguiram derrotar comercialmente as gigantes do setor, como IBM, Xerox e HP.

Os primeiros PCs vieram ao mercado a partir do ano 1978 e antes da metade dos anos 1980 já esse tipo de computador já tinha dominado o mercado.

DICA DE FILME:

O filme Piratas da Informática (1999) retrata a história real de como a Apple (com Steve Jobs) e a Microsoft (com Bill Gates) competiram pela tecnologia do computador pessoal e da interface gráfica.

A Internet

No Brasil por uma questão histórica fomos induzidos a confundia a Internet com a Web e acabamos tratando-as como se fossem uma coisa só. Porém elas são duas tecnologias diferentes, surgirdas em momentos diferentes da história e por motivos bastante distintos.

A internet é basicamente a tecnologia da infraestrutura que permite a interconexão entre computadores que estejam distantes geograficamente. Quando falamos de Internet devemos pensar em satélites, cabos de fibra óptica, servidores, protocolos de transferência de informação... E não em sites e redes sociais, pois esses só existem a partir do surgimento de outra tecnologia: a web, que veremos mais adiante.

Motivada pelo conflito com a União Soviética durante a Guerra Fria, a Advanced Research Projects Agency (ARPA), uma agência ligada ao Departamento de Defesa dos Estados Unidos, propos e conduziu a criação da Internet na década de 1960. Seu objetivo é tornar o sistema de computação de informações militares dos EUA menos vulnerável a um ataque soviético.

A ARPA decidiu que os computadores militares dos estados unidos fossem descentralizados e que pudessem se comunicar entre si. Porém a tecnologia para tornar isso possível não existia e os militares não tinham como desenvolvê-la sozinhos.

Então eles envolveram universidades e institutos de tecnologia dos Estados Unidos no desenvolvimento de uma solução e assim, no ano de 1965 já era possível conectar computadores à distância por meio de uma rede chamada ARPAnet, que mais tarde foi rebatizada para Internet.

A WEB

Perceba que o desenvolvimento do computador (a partir dos anos 1940) e da internet (a partir dos anos 1960) foram processos paralelos e independentes. Somando-se a isso a disseminação dos computadores pessoais na década de 1980 foram criadas as condições para que essas tecnologias se tornassem muito populares ao ponto de muitas pessoas terem computadores em casa.

Essas duas correntes de desenvolvimento de tecnologia (o computador pessoal e a internet) então convergiram para um ponto em comum.

No ano de 1989 um pesquisador do CERN (Centro de Pesquias Nucleares da Europa) chamato Tim Berners-Lee propos a criação de um sistema na internet que pudesse ser acesso por computadores pessoais e que facilitasse a disseminação dos trabalhos científicos que ele e seus parceiros realizavam.

Naquele ano ele publicou um documento que basicamente criava a linguagem HTML e os programas Navegadores. Essa tecnologia foi batizada de World Wide Web (rede ao redor do mundo), que conhecemos simplesmente como web ou www.

Desde então a web se desenvolveu e se tornou popular passando por algumas fases:

1) Web Sintática ou Web 1.0: um momento em que o foco da web era migrar os conteúdos das mídias analógicas para as digitais. Nesse momento basicamente a web era composta por páginas estáticas com conteúdos fixos produzidos por poucas pessoas ou organizações e publicados para ser lido por outras.

2) Web Social ou Web 2.0: movimento que se consolidou a patir do estouro da bolha da internet, na virada do ano 1999 para 2000. Nesse período a web ganhou ferramentas que privilegiam a ação do usuário, tornando-o mais ativo e permitindo que qualquer pessoa pudesse produzir informações e publicá-las na rede. Isso ficou bastante evidente com o surgimento das Redes Sociais, que começaram a se popularizar por volta do ano 2004.

3) Web Semântica ou Web 3.0: uma web que ainda se anuncia, em que "os computadores poderiam compreender documentos por meio de informações estruturadas, tanto de forma manual como automática" (VECHIATO; VIDOTTI, 2014, p.69) e com isso conseguiriam nos apresentar informações com mais naturalidade e precisão.

O computador, a internet e a web nas organizações

Para as empresas essas três tecnologias representaram impactos diferentes em três momentos diferentes:

- As empresas adotaram os computadores que, como toda tecnologia, potencializaram a realização de alguns processos tornando-os mais eficientes;

- Os computadores se conectaram à internet, permitindo às empresas, principalmente aquelas que atuam em diferentes lugares geográficos, maior integração em sua operação e melhores contatos com seus fornecedores e distribuidores.

- A web melhorou a comunicação das empresas com seus consumidores por meio de websites (desde a Web 1.0) e redes sociais (com a Web 2.0).

Porém essas tecnologias também tiberam outro efeito importantes: elas mudaram profundamente o estilo de vida e o comportamento de consumo das pessoas, pressionando as empresas para que adotem modelos de negócio diferentes, mais conectados e adaptados ao mundo digital.

Referências

DICIONÁRIO de informática, multimídia e realidade virtual. São Paulo: Melhoramentos, 2001.

GATES, Bill. A Estrada do Futuro. São Paulo: Companhia das Letras, 1995.

VECHIATO, Fernando Luiz; VIDOTTI, Silvana A. B. Gregorio. Encontrabilidade da Informação. São Paulo: Cultura Acadêmica, 2014.

WEISER Mark. The Computer for the 21st Century. Disponível em: . Aceso em: 27 de jan. de 2015.