Computação gráfica e produção multimídia

Interfaces gráficas e imagens digitais

Os dois principais benefícios da computação gráfica são as interfaces gráficas e a possibilidade de criação de imagens digitais.

Publicado em:

23 de out. de 2015

Atualizado em:

30 de ago. de 2021

Conforme a tecnologia de desenvolveu, aumentando a capacidade de processamento e armazenamento de informações digitais por parte do computador, começou a ser possível apresentar e criar imagens digitais na tela do computador, nascendo assim a chamada Computação Gráfica.

Esse recurso trouxe dois benefícios diretos aos usuários: 1) as interfaces gráficas e 2) a possibilidade de criação de imagens digitais.

Interfaces Gráficas

O primeiro benefício ao usuário proporcionado pela Computação Gráfica foi a criação das chamadas Interfaces Gráficas do (Graphical User Interface – GUI), que substituíram os comandos de texto dos Sistemas Operacionais antigos. As Interfaces Gráficas somente se tornaram possíveis em meados da década de 1980 (GATES, 1995).

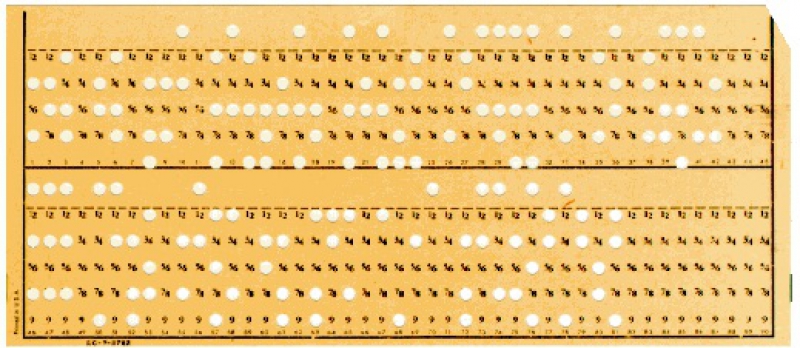

Interfaces são a maneira com que as máquinas e os humanos se comunicam. Antes das aplicações gráficas, toda essa comunicação era realizada por meio de processos analógicos – como cartões perfurados – ou textualmente por meio do teclado.

Cartão Perfurado: Exemplo de Interface Analógica

As modernas interfaces gráficas representam funcionalidades da máquina por meio de imagens, cores, botões e outros elementos visuais, acionáveis por meio do teclado, mouse ou até mesmo por comandos de voz.

A criação de uma interface possível entre a linguagem da máquina e a linguagem do computador é um problema de pelo menos seis décadas, que parece ter sido inaugurado quando Claude E. Shannon e Warren Weaver, em 1948, vislumbraram um método de aproximação entre o processo de comunicação e a matemática, com o objetivo de converter a comunicação humana em “unidades mensuráveis de informação” capazes de serem codificadas, transmitidas e decodificadas.

Sua solução, no entanto, passou a ser mais provável a partir de 1968, quando Doug Engelbart apresentou os primeiros protótipos de um sistema capaz de relacionar informação com espaço, posicionando de maneira inteligível em uma tela, os símbolos do computador (JOHNSON, 2001).

Desde então, as Interfaces Gráficas do Usuário evoluíram sua estratégia de comunicação até culminar com a utilização de metáforas visuais e outros recursos de linguagem para a formação de sentido.

Apesar de revolucionária, a aplicação das interfaces gráficas em computadores se deu quase que por acaso, pois mesmo as empresas dominantes do setor da informática nos anos 1960 e 1970, como IBM, HP e Xerox, não enxergavam nelas algo viável e praticamente as ignoraram.

O primeiro computador pessoal baseado em uma Interface Gráfica do Usuário foi Apple Lisa, lançado em 1983. A tecnologia da interface gráfica e do mouse que equipava esse computador foi praticamente doada pela Xerox para a Apple.

Assim, os engenheiros da Xerox Parc começaram a desenvolver imagens gráficas de uso fácil que pudessem substituir todas a linhas de comando e mensagens do DOS que tornavam as telas de computador intimidantes. A metáfora que eles sugeriram foi a de um desktop [mesa de trabalho]. A tela poderia conter muitos documentos e pastas, e o usuário poderia usar o mouse para apontar a clicar sobre o que quisesse usar. (ISAACSON, 2011, p.113)

Imagens Digitais

O segundo benefício trazido aos usuários pela Computação Gráfica foi a possibilidade de criação de Imagens Digitais. Por meio de programas especializados (aplicativos) os computadores passaram a permitir que os usuários transferissem imagens do papel para o computador ou que criassem as imagens no próprio computador para depois transferir para o papel.

Essa capacidade é tardia na história da informática, pois demanda uma capacidade gigantesca de processamento e armazenamento de dados, o que só foi possível após uma série de avanços tecnológicos.

Para se ter uma ideia da complexidade desse feito e para se quantificar o volume de informações com o qual o computador precisa lidar para se armazenas uma imagem, é necessário compreender como ele faz isso.

Sabemos que toda informação tratada ou armazenada pelo computador é convertida para o Sistema Binário. Por esse sistema, qualquer informação pode ser representada por uma sequência de outras informações mais simples.

E a informação mais simples que pode haver é sempre representada por um binômio: sim ou não, existe ou não existe, ligado ou desligado. Na informática, essa unidade mais simples de informação é representada pelos números zero e um.

Sendo assim, tudo o que vemos na tela de um computador ou tudo o que está armazenado em sua memória, está representado por sequências de zeros e uns, inclusive as imagens.

A tela dos monitores de computador é formada por pequenos pontos de luz dispostos em linhas e colunas, de modo que cada um desses pontos possua uma coordenada cartesiana (com uma posição X,Y na tela). Para se exibir uma imagem na tela, cada um desses pontos representa na forma de luz uma pequena informação registrada na memória do computador.

A título de exemplo, imagine que, caso a informação armazenada na memória do computador seja o número zero, esse ponto de luz estará apagado, portanto exibirá a cor preta. E, caso a informação armazenada seja o número um, a luz estará acesa e, portanto, será exibida a cor branca.

Imagine um monitor modernos, no padrão Full HD. Esse monitor possui 1.920 colunas e 1.080 linhas de pontos de luz, o que equivale a 2.073.600 pontos de luz na tela.

Levando-se em conta que os monitores modernos possuem, em geral, uma taxa de atualização de 60 Hertz, significa que uma imagem com essa quantidade de pontos de luz é gerada na tela 60 vezes por segundo.

Nesse cenário o computador precisaria processar 124.416.000 unidades de informação para manter essa imagem na tela por um único segundo.

Isso corresponde a 15.552.000 Bytes, que correspondem 15.187,5 Kilobytes, que correspondem a 14,83 Megabytes. Não parece muito, certo? Mas pense o seguinte: nesse exemplo, as cada ponto de luz na tela só poderia representar duas cores: preto ou branco. Ou seja, essa imagem que demandaria 14,83 Megabytes de informação para ficar apenas 1 segundo na tela, seria em preto e branco.

Para representar uma imagem colorida, o computador utiliza um recurso chamado profundidade de bits. É como se cada ponto de luz fosse formado por várias camadas de informação ao invés de apenas uma.

É comum os monitores trabalharem ou 8, 16 ou 32 bits em cada ponto de luz. Ou seja, para se obter uma imagem coloria, é necessário multiplicar por 8 o volume de informação necessário, o que daria 118,65 Megabytes... Por segundo!

Ou seja, o computador precisa ser muito potente para trabalhar com Computação Gráfica.

Esse método apresentado acima, de dividir a tela em pontos de luz com coordenadas cartesianas é apenas uma forma de se representar imagens na memória do computador. Esse método é chamado Raster ou Bit Map (mapa de bits).

Existe, ainda um segundo método para a geração de imagens digitais chamado Vetorial, em que os desenhos na tela se baseiam em vetores matemáticos.

Referências

GATES, Bill. A Estrada do Futuro. São Paulo: Companhia das Letras, 1995.

ISAACSON, Walter. Steve Jobs. São Paulo: Companhia das Letras, 2011.

JOHNSON, Steven. Cultura da Interface: Como o computador transforma nossa maneira de criar e comunicar. Rio de Janeiro: Jorge Zahar, 2001.

SHANNON, Claude E. A Mathematical Theory of Comunication. Bell System Technical Journal, 1948. Disponível em . Acesso em: 04 out. 2011.